随着 AI 工作负载呈指数级增长,即使是一个简单的查询也可能触发复杂的计算、存储访问和数据移动链——每一步都会消耗大量能源。这种能源激增的核心是高性能 GPU,尤其是 NVIDIA 的 GPU,它们至今仍是大多数 AI 基础设施的支柱。

尽管替代芯片正在逐渐涌现,但 NVIDIA 生态系统仍然决定着现代数据中心的散热和功耗。如果没有有效的冷却,这些强大的芯片根本无法达到其设计的性能或部署密度。

根据国际能源署的数据,预计到 2030 年,数据中心的用电量将达到近 1,000 TWh,是 2024 年的两倍多。这标志着年增长率持续达到 12%,使该行业占全球电力消耗总量的 1.5%。

但计算能力只是整个方程式的一半。输入芯片的每一千瓦功率都会转化为热量,而这些热量必须转移到某个地方。ABI 的研究表明 37% 数据中心总能量的很大一部分仅用于冷却。

冷却正在成为核心制约因素

十年前,建设一个1MW的数据中心就已经被认为是一项重大工程。如今,超大规模数据中心的规划功率已达到数百兆瓦——到2027年,NVIDIA的目标是每个机架的功率达到1MW。与此同时,ABI预测,到2030年,公共数据中心的数量将增加四倍。

这种快速扩张不仅仅是为了增长,而是为了应对热压力。虽然处理器的速度越来越快,效率越来越高,但传统的风冷系统已经达到了极限。它是为过去的工作负载设计的,而不是今天的人工智能模型。

冷却不再只是幕后功用,而是一项战略能力。根据 Uptime Institute 的数据,22% 的运营商已经采用了某种形式的直接液冷 (DLC)。但大多数部署仍然是定制且复杂的,尤其是在 GPU 集群或超大规模数据中心之外。

这种临时模型无法支持下一代人工智能。

让液体冷却成为新标准

为了跟上计算创新的步伐,冷却系统必须像服务器或存储基础设施一样实现模块化、可扩展和可维护。无论是新部署还是对现有机房进行改造,数据中心的冷却系统都必须具有可重复性、可预测性且易于维护。

对于运行全球云服务的超大规模企业,或处理实时财务数据的企业来说,停机已不再是可选项。冷却基础设施必须从定制硬件发展为标准化平台。

Coolnet 液体冷却亮点

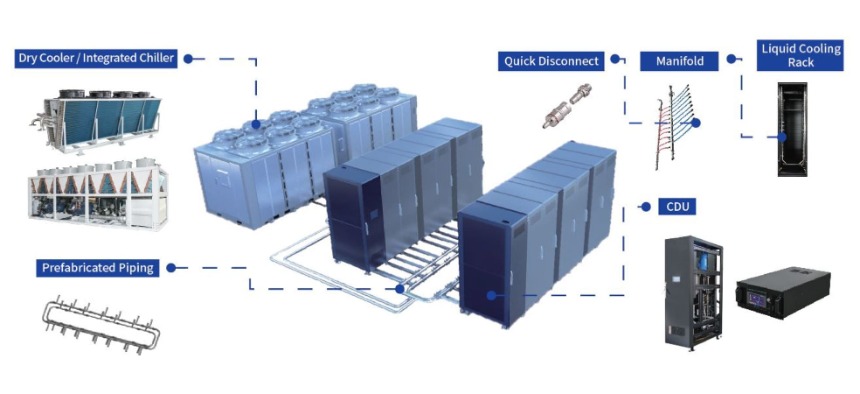

为了满足高密度计算和快速部署的需求,Coolnet 提供了专为现代数据中心设计的全系列模块化、可扩展液体冷却产品。

迷你风扇墙

集成风扇和热交换器系统,非常适合中小型数据中心或边缘数据中心。具有动态风扇转速控制、易于安装和高能效等特点。

冷冻水后门热交换器

安装在服务器机架后部,利用冷冻水散热。兼容标准IT设备,提升整体冷却性能。

排式液冷CDU

该 CDU 位于机架之间,为液冷服务器提供精准冷却。支持集中监控、前端维护和高容量性能。

浸入式液冷解决方案

该解决方案专为超高密度应用而设计,将服务器浸入导热介电流体中。提供卓越的冷却效率,最大限度地节省空间,并显著降低冷却系统的功耗。

Coolnet 提供液体冷却平台——灵活、高效,并可随着人工智能和高性能计算的未来而扩展。

联系我们了解更多信息或请求定制解决方案!

电子邮件: info@coolnetsystem.com

电话/Whatsapp: +86- 18326091011